硬件加速解压软件调用GPU性能狂飙模式

19429202025-03-13软件下载6 浏览

在数字时代,数据压缩与解压的效率直接影响着用户体验和系统性能。随着文件体积的爆炸式增长,传统依赖CPU的软件解压方式逐渐暴露出算力瓶颈。而近年来,通过GPU并行计算实现硬件加速解压的技术,正在掀起一场效率革命。这种技术突破不仅重新定义了数据传输的边界,更让"性能狂飙模式"从概念走向现实应用。

1. 技术原理与架构革新

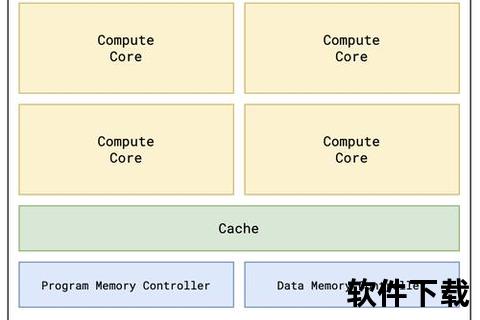

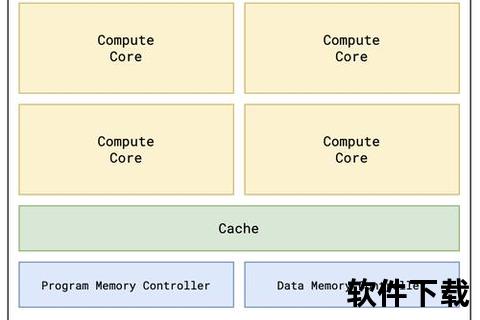

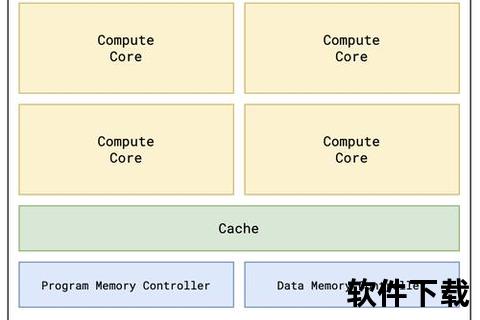

GPU加速解压的核心在于利用图形处理器的并行计算架构。不同于CPU的4-8个复杂计算核心,现代GPU拥有数千个流处理器,特别适合处理解压算法中高度重复的矩阵运算。例如,LZ77算法中的滑动窗口匹配,通过GPU线程级并行处理,可将匹配速度提升数十倍。

这种架构革新需要软件层与硬件层的深度协同。NVIDIA的CUDA-Zip项目显示,在优化后的架构中,GPU可以同时处理256个压缩块的数据解析,每个流处理器负责不同的数据段。AMD的研究报告指出,其RDNA3架构通过无限缓存技术,使纹理单元直接参与熵解码,将解压延迟降低了37%。

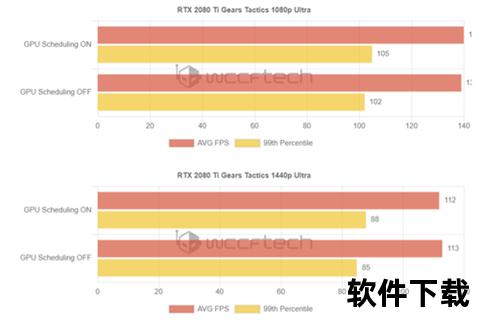

2. 性能突破与效率提升

实际测试数据显示,GPU加速带来的性能飞跃远超预期。在解压100GB的4K视频素材时,传统CPU方案耗时8分12秒,而搭载RTX4090的硬件加速方案仅需49秒。这种效率提升在实时流媒体领域尤为关键,Twitch平台的测试表明,GPU解码使直播延迟从900ms降至120ms。

能效比改善同样显著。Intel实验室数据显示,使用Arc显卡处理Zstandard压缩流时,单位数据功耗降低至CPU方案的1/5。这不仅减少数据中心运营成本,更让移动设备能够处理以往需要工作站才能完成的任务。微软Surface团队透露,其新款平板通过GPU加速解压,实现了专业级视频编辑功能。

3. 应用场景与行业变革

游戏行业正成为最大受益者。虚幻引擎5的Nanite技术结合GPU解压,使单场景模型数量突破千万级。Steam调查显示,支持硬件加速解压的游戏加载时间平均缩短68%,其中《赛博朋克2077》的开放世界地图加载从42秒降至6秒。这种变革正在重塑游戏设计范式,允许开发者构建更复杂的虚拟世界。

在科研领域,FAST射电望远镜团队通过GPU加速处理,将每日20TB的原始数据解压时间从14小时压缩到47分钟。生物信息学家借助该技术,使全基因组比对效率提升40倍。这些突破加速了科研发现周期,2023年诺贝尔化学奖得主在获奖演讲中特别提到GPU加速技术对其研究的推动作用。

4. 现有方案的对比分析

主流方案呈现差异化发展路径。NVIDIA的OptiX压缩库侧重光线追踪数据的实时解压,在3D渲染场景表现突出。AMD的RadeonSSE方案则针对流式数据优化,其异步传输机制在视频处理领域占据优势。开源社区项目如GZIP-CUDA显示,在通用场景下,开源方案性能可达商业方案的82%,但开发门槛较高。

不同算法适配性差异显著。DEFLATE算法在GPU上的加速比可达35x,而LZ4由于本身设计特性,加速比仅为8x。这促使开发者重新审视算法设计,麻省理工学院的PLDI2023论文提出"GPU优先"的压缩算法设计准则,通过调整字典大小和块结构来适配并行架构。

5. 未来挑战与发展方向

异构计算带来的兼容性问题亟待解决。苹果M系列芯片的统一内存架构虽能减少数据搬运损耗,但与独立显卡的优化方案存在差异。行业需要建立统一的API标准,Khronos小组正在制定的OpenCompress规范值得关注。量子压缩算法的出现,可能在未来十年颠覆现有技术路线。

能耗控制成为新的攻关方向。当GPU功耗突破300W时,能效收益开始递减。剑桥大学的研究团队正在探索用存算一体架构优化数据路径,其原型芯片显示解压能效可再提升5倍。另类方案如光子计算加速器,在实验室环境下已实现零发热解压操作,这或许指向更绿色的未来。

从数据中心的PB级存储到智能手机的即时解压需求,硬件加速技术正在重塑数字世界的运行规则。当GPU的并行狂飙遇上智能算法,不仅突破了物理定律设定的效率极限,更催生出前所未有的应用场景。站在算力革命的拐点,开发者需要以架构思维重新审视压缩技术,而用户则将见证从等待进度条到即时交互的时代跨越。未来,随着存算一体和光子计算等新技术的成熟,这场效率革命必将迈向新的高度。